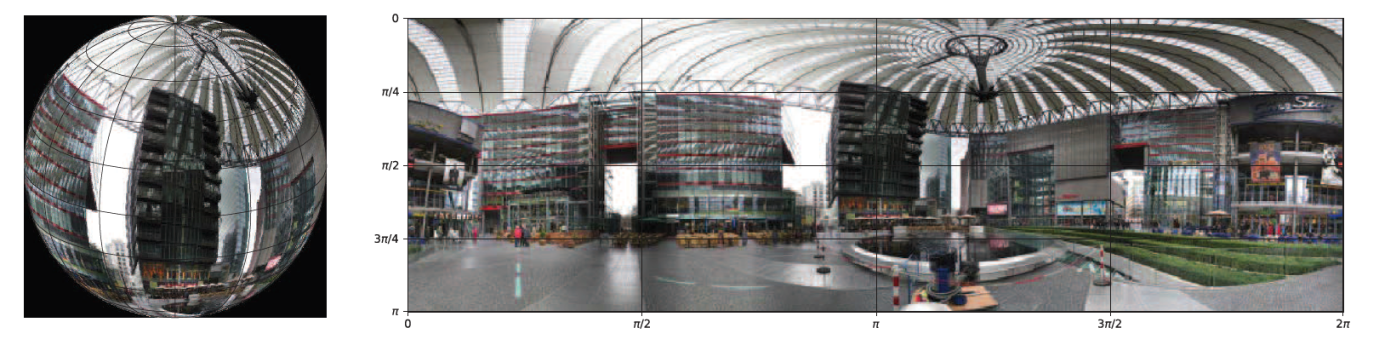

近些年来,360度全景图像或视频因其带给观察者身临其境的观看体验而引发越来越多的关注。但全景图像或视频是一种非欧几里得数据,即这些数据实际上是以二维数据的形式进行存储。人们需要用等矩阵映射(equirectangular projection)把数据从球面映射到平面如下图。等矩阵映射是一种简单的投影方式,它将经线映射为恒定间距的垂直线,将纬线映射为恒定间距的水平线,这就导致二维数据形式存储的360度全景图相比于人们真实感知的场景具有相当大的失真。因此,基于360度全景图像视频理解需要考虑这些投影失真,以便提升图像理解的性能。

图.(a)原始球面上的360图片,(b)经过投影变换后全景图上的360图像。

上科大信息学院高盛华课题组针对360度的全景图像视频理解问题,提出一种新型的球状卷积神经网络(Spherical Convolutional Neural Networks)新型深度网络,该网络包括球状卷积操作、球状池化操作、球状卷积LSTM单元和球状均方差损失函数(MSE)。相比于标准的卷积神经网络,该网络将等矩阵映射时候导致的物体形状失真考虑其中,可以提取到鲁棒的视觉特征。近期,这项研究成果“Spherical DNNs and Their Applications in 360 Images and Videos” 发表于人工智能领域顶级学术刊物IEEE Transactions on Pattern Analysis and Machine Intelligence(简称IEEE TPAMI)。

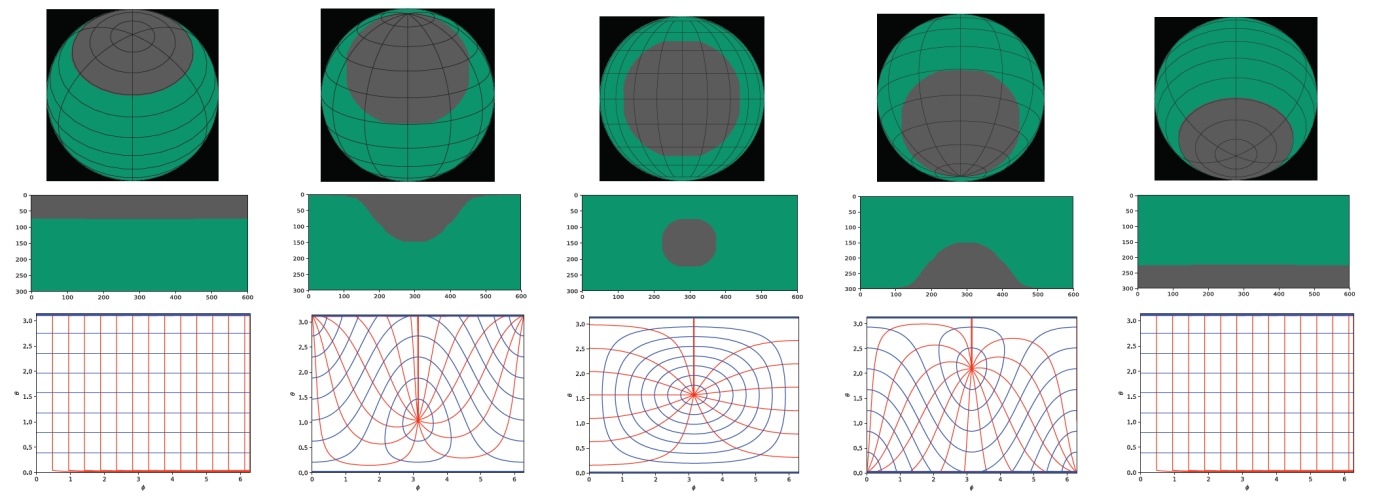

假设定义球面卷积是以北极点为中心半径为ɑ的圆锥所相对应的球冠。当课题组用这个球面卷积对映射之后得到平面图像进行卷积时,会基于所需卷积区域在球极坐标系中的位置,通过双线性差值来拉伸或者旋转卷积核。他们所提出的球状卷积还可以在球极坐标系统上的所有位置实现参数共享。不仅如此,他们还根据每个像素所在立体角的位置,赋予不同的权重,以此把用在平面图像或视频中的标准MSE损失函数扩展到全景图像或视频中,结果证明,该方法在显著性检测等任务中优于现有模型。

课题组所提出的球状卷积的参数共享示意图。该图显示球冠是如何从北极点(第一列)经过赤道(第三列)然后移动到南极点(第五列),两列之间角度差等π/4。第一行显示的是在原始球面上球冠的区域。第二行显示的是在经过映射变换之后的全景图像上球冠的区域。第三行显示的是与每个球冠卷积核位置相对应的采样网格。红色曲线代表θ方向的采样网格,蓝色曲线代表Φ方向的采样网格。

此项研究由上海科技大学、新加坡科学院等单位协作完成。上科大信息学院2020届博士生徐衍钰(目前在新加坡科学院高性能计算所工作)和2020届硕士生张子恒为共同第一作者,高盛华教授为通讯作者。该项工作得到了上海市自然科学基金以及国家自然科学基金等项目的大力支持。

沪公网安备 31011502006855号

沪公网安备 31011502006855号