信息学院王浩课题组与合作者在深度神经网络模型压缩算法研究中取得重要进展, 提出了一种基于非凸稀疏优化的神经网络模型压缩算法。相关成果以“A Proximal Iteratively Reweighted Approach for Efficient Network Sparsification”为题在计算机科学领域学术期刊 IEEE Transactions on Computers上在线发表。

深度神经网络 (DNN) 作为现代人工智能领域中最受关注的领域, 已经成为语音识别、计算机视觉、自动驾驶等诸多人工智能任务中最有前途的方法之一。 同时, 随着边缘计算和物联网技术的发展, 边缘人工智能将DNN模型的训练和推理过程直接部署在网络边缘。但是, 先进的DNN通常有着数量巨大的连接权重和神经元, 这对内存以及计算能力有限的边缘设备部署DNN来进行模型推理提出了巨大的挑战。

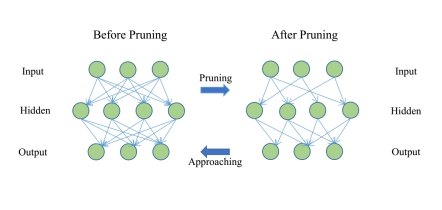

为了克服上述挑战, 网络稀疏化被视为非常有效的模型压缩方法。从算法角度讲, 这类网络稀疏化方法能高效地去除冗余的权重连接, 从而降低内存访问以及计算操作数, 且几乎不影响网络的性能。研究团队首先提出了一种基于对数求和函数以及新的约束松弛条件下的非凸优化模型。 该模型通过控制网络权重参数矩阵的稀疏结构来实现网络剪枝, 并且保证剪枝后的网络与原始网络有着相近的性能表现。但是, 该模型的非凸非光滑性质导致在计算上较难处理且较难分析。为此,研究者通过一种新的近邻迭代重加权方法,求解了一序列的加权l1范数的子问题。为了进一步提高迭代求解效率, 研究者还设计了一个实用的非精确子问题终止准则来减少剪枝时间。基于原-对偶间隙的估计, 该终止准则可以反映出对子问题的求解程度并且对大规模优化问题有着良好的适用性。

此外, 研究者还对以上算法进行了全局收敛性分析, 证明了对于带有凸集约束的非凸优化问题, 算法的迭代点可以从任意的可行初始点收敛到问题的一阶驻点。最后, 文章还给出了所提算法在遍历意义下的最坏情况 O(1/k)收敛速度。

此项研究由上海科技大学、南京大学等单位协作完成, 上海科技大学是该研究的第一完成单位。信息学院王浩教授为第一作者。该研究得到国家自然科学基金委的大力支持。

文章链接:https://ieeexplore.ieee.org/document/9291425/authors#authors

图: 具有1个隐藏层的网络以逐层方式权重剪枝的图示。稀疏连接提供较少的权重连接, 而剪枝后模型的输出仍接近未剪枝模型的性能。

沪公网安备 31011502006855号

沪公网安备 31011502006855号