随着深度学习技术的不断进步,人工智能被广泛应用在人机交互、推荐系统、安全防护等各个领域。近年来深度神经网络的安全性问题也受到了广泛的关注。一些简单的对抗样本生成技术就可以让复杂的神经网络完全失效。该技术通过对数据的细微修改,在用户感知不到的情况下,可以使机器做出错误判断,造成严重后果。在安全领域难以找到能搞定一切的“银弹”,更不会有一劳永逸的“安全永动机”,因此研究对抗样本的攻击与防御是一项重要而又艰巨的任务。为积极响应国家网络空间安全战略,信息学院宋富课题组与合作者在该领域进行了长期的研究,并取得了重要进展。

4月19日,课题组题为Attack as Defense: Characterizing Adversarial Examples using Robustness的论文被第三十届软件测试与分析国际研讨会(ACM SIGSOFT International Symposium on Software Testing and Analysis,ISSTA 2021,CCF-A)会议接收。

研究人员提出了一种基于鲁棒性差异的对抗样本区分方法,并创新地使用对抗样本攻击技术作为高效的鲁棒性评估指标,实现了变攻为防的对抗样本检测算法。实验结果显示,该方法在对抗样本检测精度和效率上均超过了现有的前沿工作。同时,这一对抗样本检测算法可以与其他防御方法高效结合(例如对抗训练等),经过结合后的防御可以抵抗更强的针对性攻击。

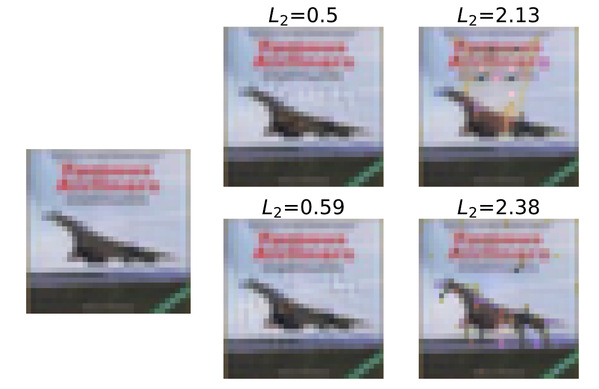

防御效果展示

上图用实例展示了该防御方法的效果。其中第一列为一张可以被分类为飞机的正常图片,第二列为攻击者生成的对抗样本(此时未对神经网络进行防御)。这些样本可以让神经网络出错,将飞机误分类为猫和马。而在使用本文中提出的检测算法和对抗训练之后,攻击者无法再使用很小的扰动使神经网络出错,如果想要绕过该检测方法,攻击者只能生成类似第三列的图片。但此时图片已经失去了原有的特征信息,扰动变得显而易见,此时人类面对这两张图片也难以辨别其所属的类别,不再符合对抗样本的定义。

此研究由上海科技大学、浙江大学、新加坡管理大学等单位协作完成,上海科技大学为本论文的第一完成单位。信息学院2019级博士生赵哲为该论文第一作者,宋富教授为通讯作者,2019级研究生陈光科、2018级本科生杨易为为共同作者。

沪公网安备 31011502006855号

沪公网安备 31011502006855号